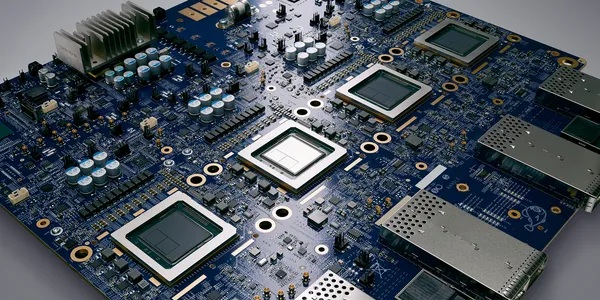

[비즈니스포스트] 엔비디아가 인공지능 연산속도를 2배가량 키운 차세대 인공지능 반도체 H200을 공개했다.

엔비디아는 현지시각 13일 홈페이지를 통해 인공지능 전문 반도체 H100의 업그레이드 버전인 H200을 소개하면서 "모든 유형의 데이터센터에 적용될 수 있으며 연산속도도 대폭 개선됐다"고 설명했다.

![엔비디아, 연산속도 2배 키운 차세대 인공지능 반도체 H200 공개]()

엔비디아는 “메타의 거대언어모델(LLM) ‘라마2’를 대상으로 테스트한 결과 H200이 기존 H100과 비교해 처리속도가 최대 2배 가량 빠른 것으로 확인됐다”고 말했다.

특히 이번에 공개된 H200은 기존 엔비디아의 인공지능 칩 H100을 활용하는 시스템과 호환되도록 설계된 것으로 알려졌다.

이에 따라 클라우드 업체인 아마존과 구글, 마이크로소프트, 오라클 등은 별다른 시스템 변경없이 H200으로 주요 연산장치를 바꿀 수 있게 됐다.

엔비디아는 이번에 공개한 H200을 2024년 2분기부터 글로벌 시스템 제조업체 및 클라우드 서비스업체에 공급하겠다는 계획도 알렸다. 다만 엔비디아는 구체적 가격에 대해서는 알리지 않았다.

하지만 현재 판매되고 있는 H100 칩의 가격이 1개당 2만5천 달러~4만 달러인 점을 감안할 때 H200의 가격은 이보다 높은 가격으로 출시될 것으로 예상된다. 조장우 기자

엔비디아는 현지시각 13일 홈페이지를 통해 인공지능 전문 반도체 H100의 업그레이드 버전인 H200을 소개하면서 "모든 유형의 데이터센터에 적용될 수 있으며 연산속도도 대폭 개선됐다"고 설명했다.

▲ 엔비디아가 연산속도를 2배가량 키운 차세대 인공지능 반도체 H200을 공개했다. 사진은 엔비디아 회사 로고.

엔비디아는 “메타의 거대언어모델(LLM) ‘라마2’를 대상으로 테스트한 결과 H200이 기존 H100과 비교해 처리속도가 최대 2배 가량 빠른 것으로 확인됐다”고 말했다.

특히 이번에 공개된 H200은 기존 엔비디아의 인공지능 칩 H100을 활용하는 시스템과 호환되도록 설계된 것으로 알려졌다.

이에 따라 클라우드 업체인 아마존과 구글, 마이크로소프트, 오라클 등은 별다른 시스템 변경없이 H200으로 주요 연산장치를 바꿀 수 있게 됐다.

엔비디아는 이번에 공개한 H200을 2024년 2분기부터 글로벌 시스템 제조업체 및 클라우드 서비스업체에 공급하겠다는 계획도 알렸다. 다만 엔비디아는 구체적 가격에 대해서는 알리지 않았다.

하지만 현재 판매되고 있는 H100 칩의 가격이 1개당 2만5천 달러~4만 달러인 점을 감안할 때 H200의 가격은 이보다 높은 가격으로 출시될 것으로 예상된다. 조장우 기자