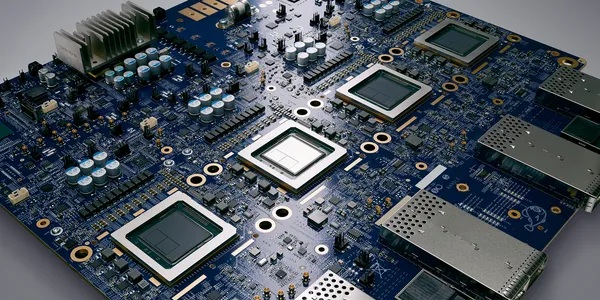

▲ 퀄컴이 고대역폭 메모리(HBM) 대신 훨씬 많은 용량의 모바일D램을 탑재하는 추론용 인공지능 반도체 제품을 공개했다. 삼성전자를 비롯한 D램 공급사에 기회 요인으로 분석된다. 퀄컴 인공지능 반도체 AI200 및 AI250 홍보용 이미지.

다만 퀄컴의 제품은 고대역폭 메모리(HBM) 대신 대용량 모바일 D램을 활용해 비용 및 전력 효율성을 높이는 형태로 기존 인공지능 반도체와 차별화된다.

27일(현지시각) 퀄컴은 내년부터 순차적으로 출시할 인공지능 추론용 가속기 ‘AI200’과 ‘AI250’을 공식 발표했다.

생성형 인공지능 서비스 구동에 최적화된 퀄컴 반도체를 기반으로 하는 데이터서버용 제품이다. 엔비디아 및 AMD의 인공지능 반도체와 직접 경쟁을 노린다.

다만 엔비디아와 AMD가 필수로 탑재하는 HBM 메모리를 사용하지 않는다는 점이 특징이다. 퀄컴은 AI200 반도체 솔루션에 768GB 용량의 LPDDR 모바일 D램을 탑재한다고 밝혔다.

메모리 용량은 경쟁사 인공지능 반도체에 적용되는 HBM 평균 탑재량보다 훨씬 높다.

IT전문지 톰스하드웨어는 “퀄컴은 엔비디아와 AMD가 주도하던 인공지능 반도체 시장에 새 경쟁자로 등장했을 뿐만 아니라 모바일 메모리를 활용해 독자적 기술 방식을 찾아냈다는 점에서 주목된다”고 바라봤다.

HBM은 일반 D램과 비교해 데이터 전송 대역폭을 높인 고사양 메모리반도체다. 이는 인공지능 반도체의 성능을 끌어올리는 데 필수 요소로 꼽혀 왔다.

그러나 퀄컴은 자체 인공지능 반도체에 HBM 대신 훨씬 많은 용량의 모바일 D램을 탑재하는 방식으로 다른 길을 선택한 셈이다.

IT 전문지 WCCF테크는 퀄컴이 HBM 대신 LPDDR D램을 채택해 전력 효율성과 원가 경쟁력, 추론 작업에 적합한 높은 메모리 밀도와 열 관리 효율성 등 장점을 얻을 것이라고 바라봤다.

다만 HBM을 사용하지 않는 만큼 엔비디아나 AMD의 인공지능 반도체 대비 성능이 낮고 아직 데이터서버 환경에서 충분히 검증되지 않았다는 단점이 있다고 지적했다.

퀄컴이 기업 고객들의 인공지능 추론 작업에 유용한 선택지를 제공할 수 있지만 해당 제품이 폭넓은 분야에서 활용되기는 어려울 수 있다는 의미다.

이번에 퀄컴이 선보인 모바일 D램 기반의 인공지능 반도체가 시장에서 경쟁력을 증명한다면 삼성전자와 SK하이닉스 등 상위 공급업체에 수혜로 돌아올 공산이 크다.

삼성전자와 SK하이닉스가 모바일 D램 시장에서 미국 마이크론과 함께 굳건한 선두 지위를 지키고 있기 때문이다.

특히 삼성전자는 HBM 기술 개발이 상대적으로 늦어 인공지능 반도체 열풍에 SK하이닉스나 마이크론 대비 큰 수혜를 거두지 못했다는 평가를 받았다.

그러나 모바일 D램 시장에서 삼성전자는 확실한 선두 기업으로 자리잡고 있는 만큼 고객사에 공급 기회도 그만큼 커질 수 있다.

더구나 D램 공급 부족으로 가격 상승세가 본격화되는 업황 호조 국면에서 인공지능 분야의 대규모 수요가 새로 발생하는 것은 중장기적으로 긍정적 요소가 될 수 있다.

WCCF테크는 “퀄컴은 추론 분야가 인공지능 시장에서 주목받는다는 점을 인식해 합리적 사업 전략을 꺼내들었다”며 “다만 인공지능 학습이나 대규모 작업에는 적합하지 않을 것”이라고 바라봤다. 김용원 기자