[비즈니스포스트] HBM(고대역폭 메모리)의 주류가 2024년에는 4~5대 제품인 HBM3과 HBM3E로 넘어갈 것이란 전망이 나왔다.

삼성전자와 SK하이닉스는 2024년 하반기부터 HBM3E을 양산할 것으로 예상됐다.

![삼성전자 SK하이닉스 내년 하반기 HBM3E 양산 전망, AI 칩 수요 급증]()

대만 시장조사기관 트렌드포스는 현지시각 1일 “2023년 현재 엔비디아의 인공지능 그래픽처리장치(GPU)인 A100, A800과 AMD의 MI200에 들어가는 HBM은 HBM2E”라며 “인공지능 반도체에 대한 수요가 진화함에 따라 2024년에는 HBM3/HBM3E가 주류가 될 것”이라고 내다봤다.

HBM은 여러 개의 D램을 수직으로 연결해 기존 D램보다 데이터 처리 속도를 큰폭으로 향상시킨 고성능 메모리반도체다.

HBM은 세대별로 HBM(1세대), HBM2(2세대), HBM2E(3세대), HBM3(4세대)로 나뉘는데 세대가 높아질수록 데이터 전송 속도가 빠르다.

현재 인공지능용 GPU에 주로 탑재되는 HBM은 3세대인 HBM2E다.

하지만 초고가 인공지능 GPU로 분류되는 엔비디아의 H100/H800 및 AMD MI300 시리즈에는 4세대인 HBM3이 들어간다. 엔비디아 H100은 1개 패키지당 가격이 3만 달러(약 3800만 원)에 달한다.

엔비디아가 2025년 출시하는 인공지능 GPU 'GB100'에는 5세대인 HBM3E가 탑재될 것으로 예상된다.

이에 따라 삼성전자와 SK하이닉스는 2024년 1분기 HBM3E 샘플을 출시하고 2024년 하반기에는 HBM3E 대량생산을 진행할 것으로 전망된다.

그동안 HBM 투자에 소홀했던 마이크론은 HBM3를 건너뛰고 HBM3E를 개발해 최근 고객사에 샘플을 보내고 있는 것으로 알려졌다.

마이크론은 HBM3E와 관련해 홈페이지에서 “마이크론이 개발한 HBM3E는 9.2Gb/s 이상의 핀(pin)당 데이터 전송률을 갖고 있다”고 설명했다. 이는 SK하이닉스가 하반기 출시를 예고한 HBM3E의 8Gb/s를 웃도는 수준이다.

글로벌 빅테크들이 만드는 자체 인공지능 반도체에서도 HBM 수요는 증가할 것으로 예상된다.

트렌드포스는 “구글과 아마존은 엔비디아와 AMD에 대한 의존도를 줄이기 위해 이미 각각 자체 인공지능 칩인 텐서플로세싱유닛(TPU)과 인퍼런시아 등을 개발하고 있다”며 “북미와 중국의 다른 클라우드업체들도 자체칩 검증을 진행하고 있어 향후 인공지능 칩 시장의 경쟁은 치열해질 것”이라고 전망했다. 나병현 기자

삼성전자와 SK하이닉스는 2024년 하반기부터 HBM3E을 양산할 것으로 예상됐다.

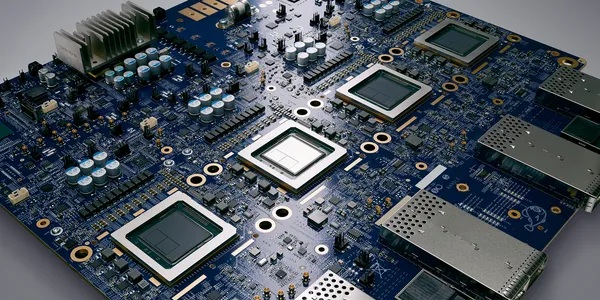

▲ 트렌드포스는 2024년 HBM(고대역폭 메모리)의 주류가 HBM3/HBM3E로 넘어갈 것이라고 1일 전망했다. 사진은 SK하이닉스가 개발한 HBM3(고대역폭메모리) 반도체. < SK하이닉스 뉴스룸 >

대만 시장조사기관 트렌드포스는 현지시각 1일 “2023년 현재 엔비디아의 인공지능 그래픽처리장치(GPU)인 A100, A800과 AMD의 MI200에 들어가는 HBM은 HBM2E”라며 “인공지능 반도체에 대한 수요가 진화함에 따라 2024년에는 HBM3/HBM3E가 주류가 될 것”이라고 내다봤다.

HBM은 여러 개의 D램을 수직으로 연결해 기존 D램보다 데이터 처리 속도를 큰폭으로 향상시킨 고성능 메모리반도체다.

HBM은 세대별로 HBM(1세대), HBM2(2세대), HBM2E(3세대), HBM3(4세대)로 나뉘는데 세대가 높아질수록 데이터 전송 속도가 빠르다.

현재 인공지능용 GPU에 주로 탑재되는 HBM은 3세대인 HBM2E다.

하지만 초고가 인공지능 GPU로 분류되는 엔비디아의 H100/H800 및 AMD MI300 시리즈에는 4세대인 HBM3이 들어간다. 엔비디아 H100은 1개 패키지당 가격이 3만 달러(약 3800만 원)에 달한다.

엔비디아가 2025년 출시하는 인공지능 GPU 'GB100'에는 5세대인 HBM3E가 탑재될 것으로 예상된다.

이에 따라 삼성전자와 SK하이닉스는 2024년 1분기 HBM3E 샘플을 출시하고 2024년 하반기에는 HBM3E 대량생산을 진행할 것으로 전망된다.

그동안 HBM 투자에 소홀했던 마이크론은 HBM3를 건너뛰고 HBM3E를 개발해 최근 고객사에 샘플을 보내고 있는 것으로 알려졌다.

마이크론은 HBM3E와 관련해 홈페이지에서 “마이크론이 개발한 HBM3E는 9.2Gb/s 이상의 핀(pin)당 데이터 전송률을 갖고 있다”고 설명했다. 이는 SK하이닉스가 하반기 출시를 예고한 HBM3E의 8Gb/s를 웃도는 수준이다.

글로벌 빅테크들이 만드는 자체 인공지능 반도체에서도 HBM 수요는 증가할 것으로 예상된다.

트렌드포스는 “구글과 아마존은 엔비디아와 AMD에 대한 의존도를 줄이기 위해 이미 각각 자체 인공지능 칩인 텐서플로세싱유닛(TPU)과 인퍼런시아 등을 개발하고 있다”며 “북미와 중국의 다른 클라우드업체들도 자체칩 검증을 진행하고 있어 향후 인공지능 칩 시장의 경쟁은 치열해질 것”이라고 전망했다. 나병현 기자